La pratique de l’évaluation est l’un des

mécanismes

prépondérant au sein des gouvernements et des organisations

contemporaines, qu’elles soient à but lucratif ou non lucratif,

où toute entités se doivent d’assurer leurs pérennités.

C’est

ainsi que deux modes de gouvernance, la compétition marchande et

le rôle étatique ont guidés ce principe omniprésent vers des

courants multiples qui se reflète de part les déviances

montantes et la pluralité de ces formes.

Le dispositif

d’évaluation s’appui sur des instruments de mesure à l’aide

d’indicateur censé être applicable pour tout type de structure

(hôpital, entreprise, association, tribunal…) ce qui contribue à

un suivi pertinent et objectif de l’évolution du processus

opérationnel et stratégique.

Or cette approche

pragmatique est fortement reprochéeselon

les

spécialistes et concernés provocant malheureusement des

symptômes organisationnels tel que les psychopathologies et

autres méfaits sociétales comme l’effet « prix

Goncourt ».

Historiquement, la rationalisation

du travail par Taylor

lors de la généralisation industrialo-capitalisme

en 1890 créa le besoin d’évaluer ce qui devint ainsi,

l’opérateur essentiel de la naissance du capitalisme. Elle prend

son essor au XIXème siècles, principalement aux Etats-Unis, pour

mesurer d’abord l’efficacité des étudiants puis du système

éducatif et de santé. L'évaluation

a fait l'objet depuis deux siècles de multiples théories qui se

confrontent, donnant lieu notamment à une bataille idéologique

entre adeptes du quantitatif et ceux du qualitatif.

Depuis quelques

années, un courant participative de l’évaluation entre en jeu,

grâce à la sociologie des organisations et des retours d’experts

tel que E.Monier,

précisant que « Le chargé d'évaluation devient un

maïeuticien, un méthodologue et un médiateur », réfutant

l’évaluateur traditionnel, également de critique

fondé, « l’essentiel de ce qu’en cherche à évaluer, se

dérobe à l’observation directe » selon C.Dejours qui

propose de « percevoir l’expérience subjective du

travail ».

C’est dans un souci

d’équité des deux visions de la pratique d’évaluation, celle de

l’objectivisme tangible traditionnel et du subjectivisme tacite

précurseur que nous souhaitons entamer une analyse préliminaire

des pratiques de l’évaluation au niveau normative et au niveau

de l’état de l’art.

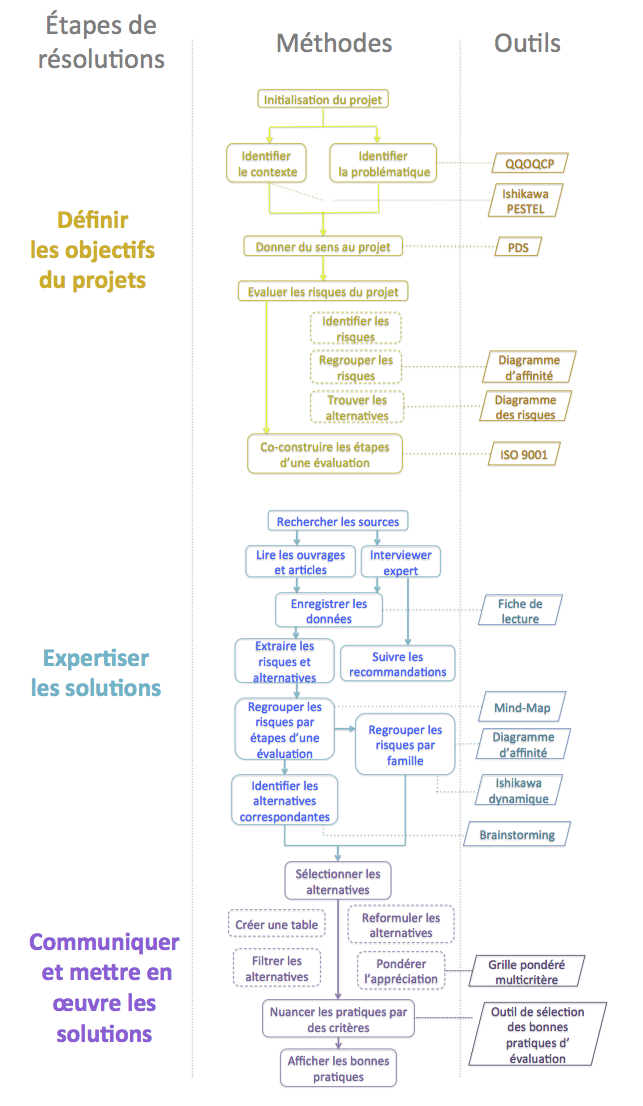

Il s’agit

donc par la suite, de clarifier le sujet sur les bonnes

pratiques de l’évaluation à l’aide d’objectifs identifiés et

mesurables puis de l’expertise et la mise en œuvre du plan

d’action défini avec comme idéal de contribuer et rendre plus

performant tout organisme en possession de ce rapport afin

d’améliorer l’efficacité, l’efficience du processus

d’évaluation et de ce fait, la performance de ces entités.

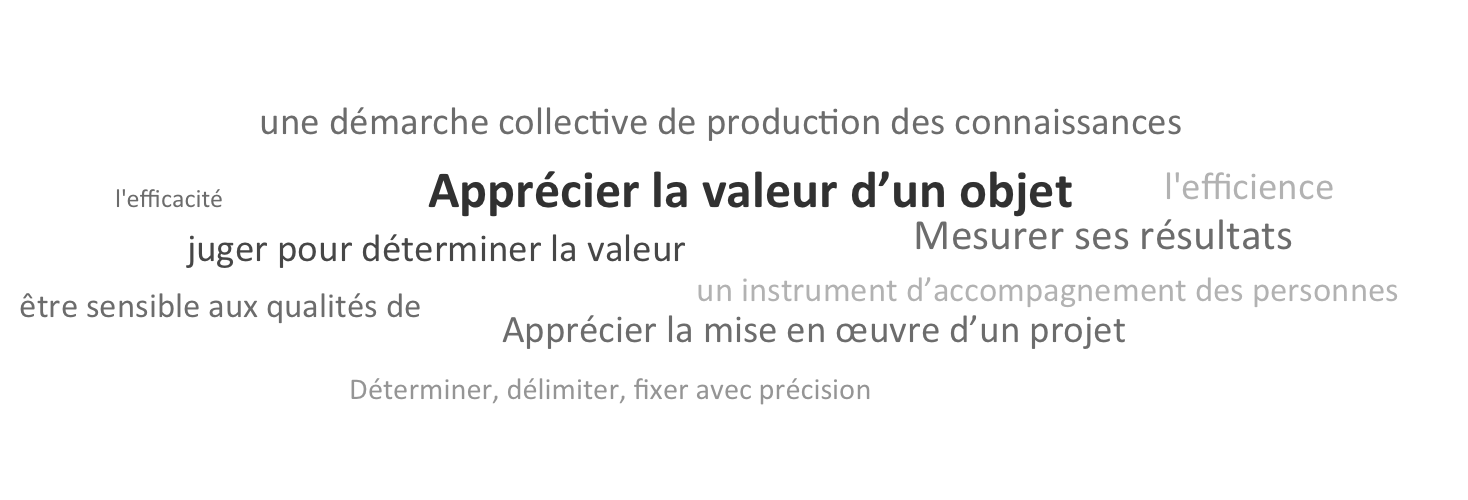

Evaluer c'est d'abord

mesurer,

mais aussi apprécier la valeur d’un projet ou d’une action, sa

mise en œuvre, ses résultats au regard des missions des

objectifs initialement prévus. Il faut donc commencer à

travailler l'évaluation dès le début de l'élaboration du projet.

L’évaluation peut s’appliquer dans n’importe quel domaine de

travail.

L'évaluation permet de

mesurer divers aspects d’un projet ou d’une action dans un

organisme: l'efficience, l'efficacité, l'impact, la cohérence et

la cohésion des gens d’une équipe. Ainsi cette technique

dite de gestion possède une polysémie

qui se diversifie sous l’expertise académique d’un article et un

contrôle de normes de qualité dans un processus productif ; ou

bien dans le suivi du chiffre d’affaire d’une organisation ;

comme dans un indice de satisfaction des usagers d’un service

social; également dans une épreuve standardisée pour comparer

les compétences scolaires des élèves, etc.

L’évaluation est aussi

pour l’équipe un processus permanent, qui doit être utilisé

comme un instrument d’accompagnement des personnes, une démarche

collective de production de connaissances.

Le mot « évaluation » peut avoir plusieurs

connotations en fonction de la perception des acteurs concernés.

Il existe de nombreuses définitions pour cette notion et c’est

dans ce cadre, que l’on entreprend de clarifier le concept

d’évaluation. Voici quelques exemples des définitions:

« Porter un

jugement sur la

valeur. Estimer,

apprécier, juger. » (Le nouveau petit Robert 1994)

« Déterminer plus

ou moins approximativement la valeur de quelque chose »

(Lexis)

« La rétroaction

planifiée et systématique d’informations nécessaires pour guider

l’action future. » (Arnold 1971)

« La collecte et

l’interprétation systématique d’évidence (données probantes)

menant, de façon inhérente au processus, à un jugement sur la

valeur (d’un programme) dans une perspective d’action. »

(Beeby 1977)

« L’analyse d’une

action raisonnée en termes de sa pertinence, son implantation et

ses résultats. » (SCE 1985)

« Le processus de

détermination de la valeur des choses. » (Scriven 1991)

Les définitions

présentées ci-dessus contiennent des mots qui montrent la

subjectivité et l’incertitude de l’évaluation, comme estimer, apprécier,

approximativement, jugement, pertinence. La subjectivité

d’un évaluateur intervient dans l’analyse des données, étant le

principal motif du

manque de confiance dans le processus d’évaluation. Comme on

sait que la rationalité de l’homme est limitée, on s’attend que

l’interprétation de la réalité diffère en fonction de

l’évaluateur. L’effet est la méfiance des acteurs concernés

regardant la mauvaise interprétation des données, donc d’une

évaluation qui ne reflète pas la réalité.

L’évaluation est

souvent perçue par les évalués comme une vérification de leur

activité et ils ont peur d’une mauvaise perception de leurs

actions. Dans la relation évaluateur-évalué intervient la notion

de confiance, qui n’est pas toujours présente.

Une seconde raison du

manque de confiance dans l’évaluation, autre que la

subjectivité, est l’incompréhension de l’activité par

l’évaluateur. Donc il n’a pas la capacité de construire un

référentiel robuste et il ne peut pas comprendre l’essentiel de l’objet analysé. La

pertinence de l’évaluation est mise en cause par les acteurs qui

ne comprennent pas toujours la nécessité de cette démarche. Il

n’est pas toujours évident d’assimiler que l’évaluation n’est

pas le but, mais uniquement un moyen d’analyser la réalité pour

la prise de décision.

La perception de l’évaluation comme un contrôle emmène à avoir

une vision binaire des choses (conforme/ non conforme). Le

processus d’évaluation donne une gradualité à chaque objet

analysé et mets en avant l’inexistence de mauvaise pratique,

mais seulement des pratiques qui peuvent être amélioré. Donc

l’appréciation des évaluateurs a un rôle informatif pour des

futures décisions.

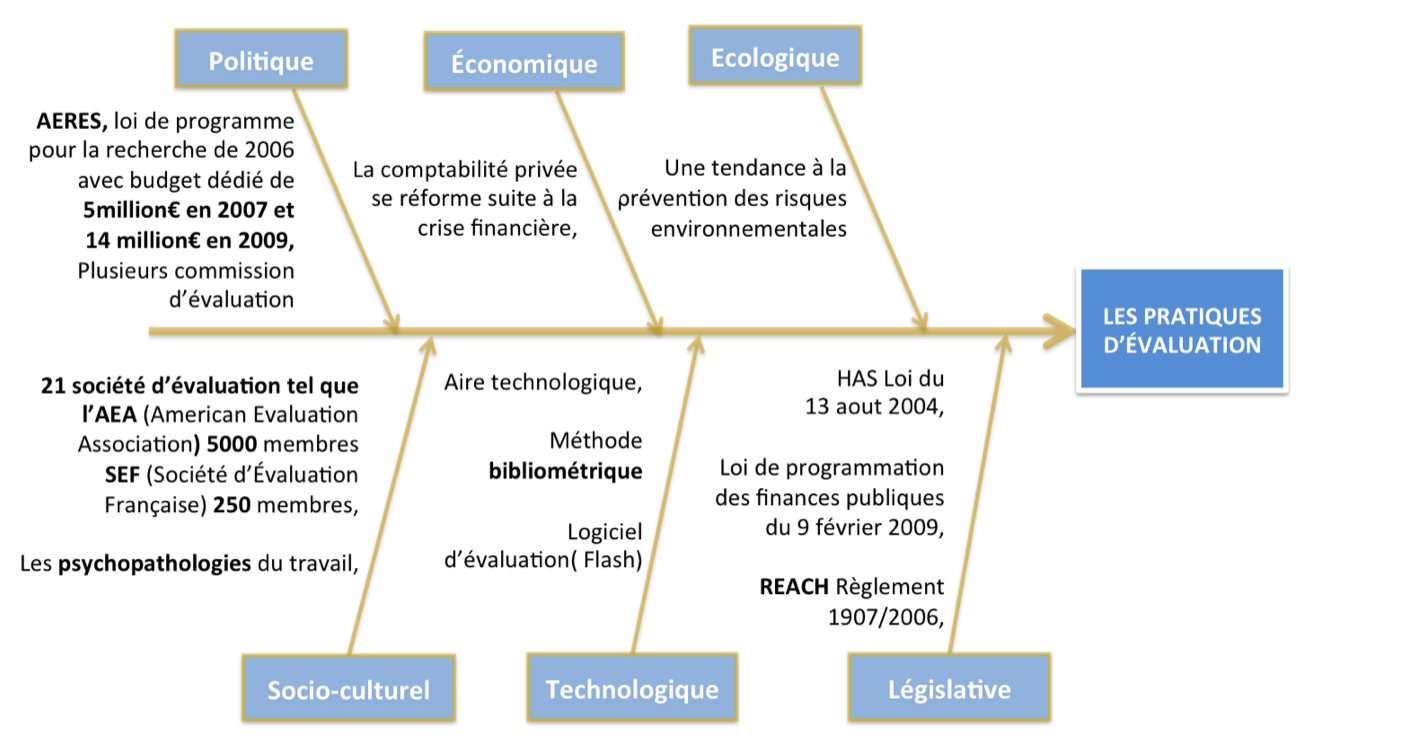

Le

contexte actuel qui entoure la

pratique de l’évaluation est très vaste, allant de la dynamique

sociétale contemporaine au fonctionnement propre des entités

étatiques mondiales, au niveau national et international, voire

d’organisme responsable de l’évaluation aux organismes qui se

font évaluer.

Par conséquent, nous allons

prospecter selon une méthode empruntée au terrain du marketing

de diagnostic de l’environnement externe. C’est à l’aide du PESTEL, étant

l’acronyme de Politique, Économique, Socio-culturel,

Technologique, Écologique et Législative qu’une description

succincte du contexte est proposée pour entrevoir en sous

parties la situation actuelle.

La

stratégie des états tend vers le contrôle, la maitrise de

fonctionnement du système et ceci passe par la mise en place de

démarche pour s’assurer que la concordance entre les objectifs

et les résultats escomptés sont le plus proche possible.

Comme en France, où en

2006, une loi de programme pour la recherchea

été mise en place ce qui a conduit à la création de l’AERES

ayant pour rôle de suivre et accompagner l’évaluation des

institutions éducatives françaises.

Dans ce climat, la progression du budget affilié à l’AERES a

triplé

en 2 ans de 2006 à 2009, ce qui connote des pistes sur

l’importance prise par les entités étatiques dans la pratique

d’évaluation.

Toujours

en France, on remarque un nombre conséquent d’organismes

nationaux d’évaluation pour des domaines spécifiques comme dans le domaine social

et socio-médical.

Au niveau législatif, en Europe

sous la gouvernance de l’U.E, on peut identifier des décrets

et lois relatifs à la pratique d’évaluation. Par exemple,

concernant l’enregistrement, l’évaluation et l’autorisation

des substances chimiques (dite règlement REACH) afin de

cadrer et maitriser dans l’union européenne la prévention des

risques environnementales. Le gouvernement Français a montré

récemment un intérêt à l’évaluation d’une partie de ces

institutions, selon l'article 12 de la loi de programmation

des finances publiques du 9 février

2009, l’ensemble des dépenses fiscales et niches sociales

existantes à cette date, à savoir 538 mesures dérogatoires

fiscales et sociales, ont fait l'objet d'une évaluation de

leur bilan coût/efficacité.

C’est

à la suite de la crise économique mondiale de 2008, que l’on

dénonça fortement le problème d’évaluation

des actifs financiers.

Cette

crise a pour origine l’évaluation financière douteuse des

risques de crédit, forte de ce constat, on remet en cause

actuellement le système de titrisation

étant l’instrument financier regretté des banques

d’investissements et des agences de notation qui déclencha à son

insu l’aide massive des états, l’argent du contribuable.

Dans

le cadre socioculturel, les répercutions de l’évaluation au sein

de la société actuel montre des symptômes de pathologie mais

aussi des fondements bienfaiteurs de l’approche de

l’appréciation de la valeur.

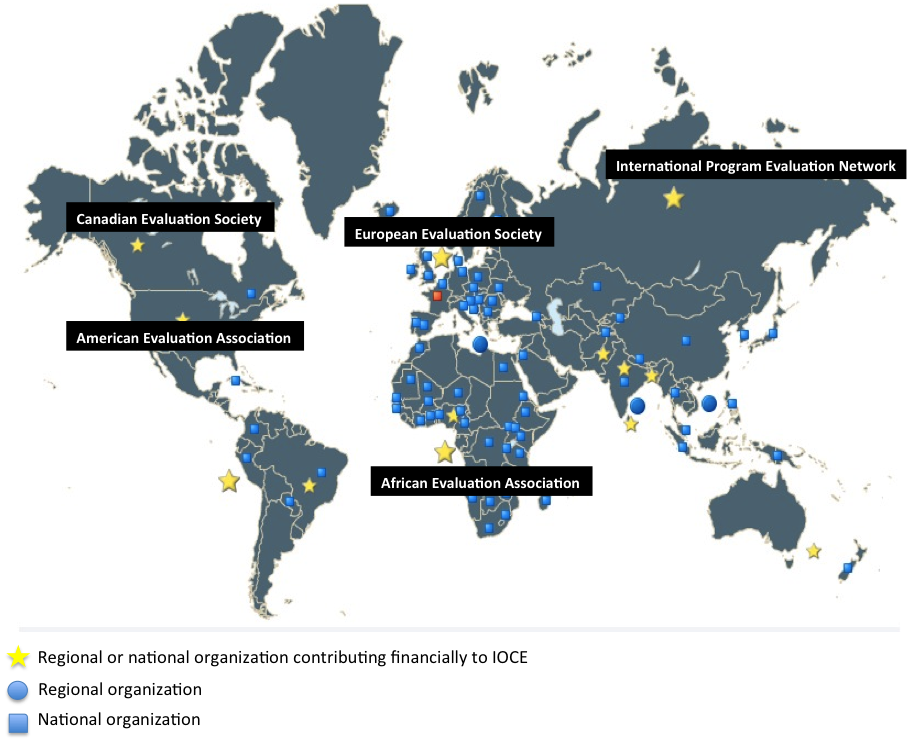

On

peut citer la démarche du gouvernement américain à la pratique

de l’évaluation au sein de ses institutions ce qui a conduit à

l’émergence d’une association dans la pratique de l’évaluation,

l’AEA.

Cette

dernière a pour

missiond’améliorer

les

méthodes et la pratique d’évaluation, promouvoir l’utilisation

et la perspective de profession de l’évaluation, contribuer à

l’apport de théorie et connaissances dans ce domaine.

Un

équivalent européen existe, l’European Evaluation Society,

qui a le but de stimuler, promouvoir la théorie et l’utilisation

de l’évaluation en Europe.

Bien

que des organismes participent à la promotion de l’appréciation

et de la mesure, au niveau des faits, des signes de déviance

datant de l’époque industrielle stagnent de nos jours et

s’accompagne de nouvelle psychopathologie qui s’accroit au fur à

mesure que la complexité des organisations s’établisse et que la

compétitivité féroce et déloyale fait jurisprudence, subis par

la mondialisation. On peut recenser que la quête de performancedans

une

entreprise par exemple, est source de déni institutionnel qui

octroie un laisser-faire des défaillances résultantes du travail

réel, ou bien que le gestionnaire devient pilote du processus

sans connaître le travail effectif de l’opérateur. Et ceci peut

engendrer des mécanismes de défenses ou différents types

d’aliénations de la part des opérateurs.

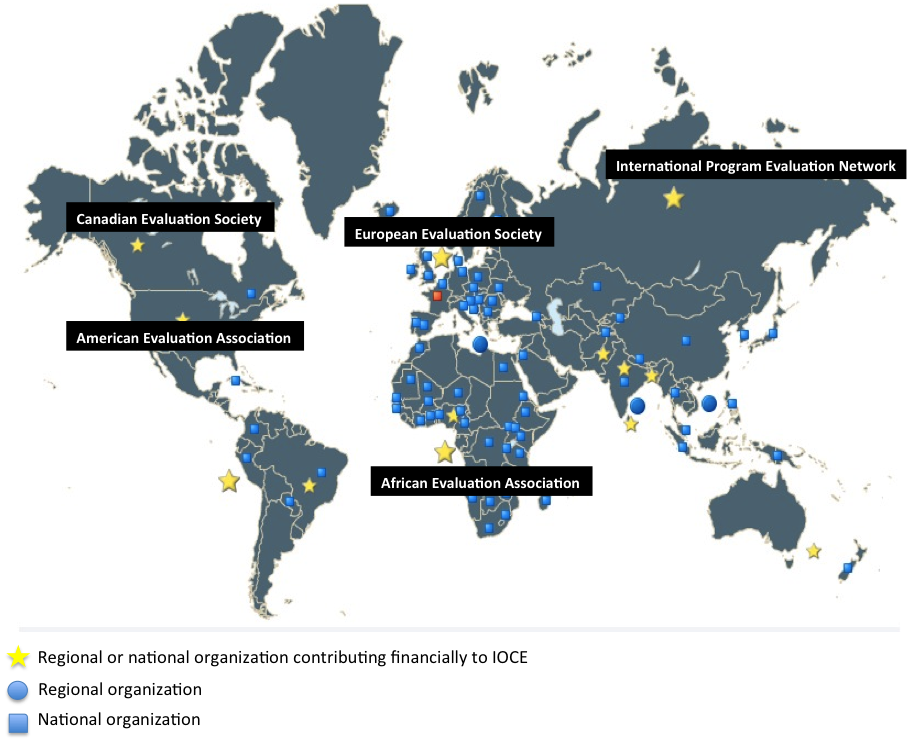

Voici un

récapitulatif des principales organisations présentent dans le

monde participant

à l’édifice de la pratique de l’évaluation :

Figure n°: 1

- les différentes organisations sur la pratique de

l'évaluation dans le monde

|

L’avancée

technologique remarquable qui se symbolise sous plusieurs traits

dans la société actuelle, connote une variété et multiplicité

des disciplines résultantes, avec des spécialisations abouties

ou en construction.

Pour ces derniers,

on peut noter que l’évaluation prend une ampleur prépondérante

et obligatoire, surtout lorsque le facteur humain et

environnemental entre en jeu. Notamment pour les nouvelles

technologies, tel que les problématiques d’éthique que pose

certaine approche, tel un commentaire émis par M. LARRÈRE :

« Est-ce

que les biotechnologies, les nanotechnologies et la biologie

synthétique relèvent d'artefacts ou de processus naturels ?

Cette question est cruciale car le sens donné à ces techniques

influera sur les dispositions éthiques et métaphysiques ».

C’est ainsi,

qu’un panorama du contexte permet de se situer par rapport à

l’état de l’évaluation dans notre époque. Ceci afin de

comprendre le périmètre du projet relatif à la pratique de

l’évaluation.

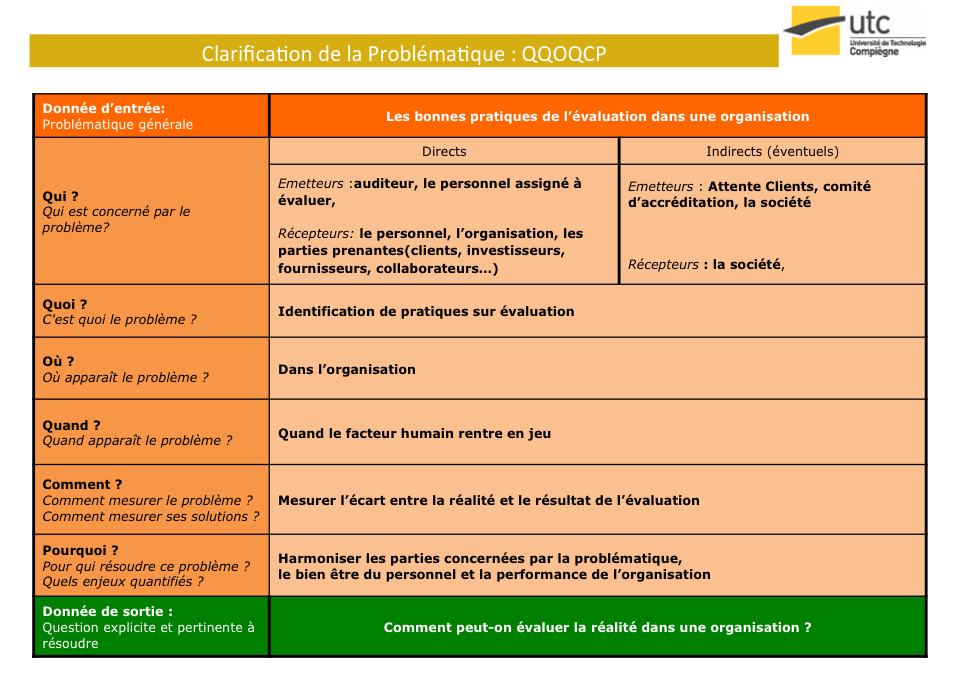

C’est à

l’aide du formalisme et du cigle QQOQCP pour Qui ? ,

Quoi ? Ou ? Quand ? Comment ? et

Pourquoi ? que nous proposons d’éclaircir le sujet

traité. Le schéma ci dessous synthétise et nous permet de

formuler la problématique que nous proposons de

résoudre :

La problématique identifiée

‘comment peut-on évaluer la réalité dans une

organisation ? ‘ nous ouvre une voix vers une démarche

d’appropriation des critiques et bienfaits de l’évaluation

afin d’identifier des bonnes pratiques de l’appréciation de la

valeur dans la réalité.

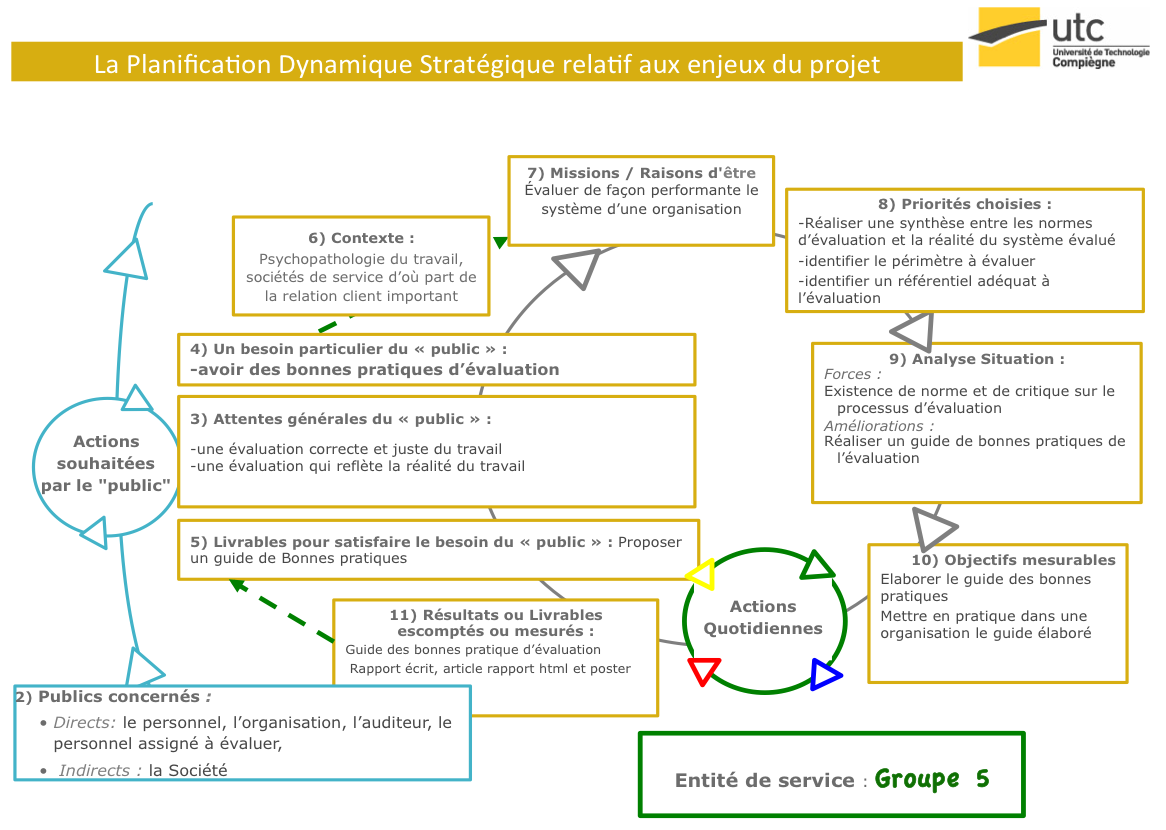

Afin

de visualiser en un coup d’œil les enjeux relatifs au projet, la

représentation graphique de la planification stratégique dynamique

nous permet de situer les acteurs environnants, la mission et

les objectifs du projet par rapport à l’équipe qui agisse à sa

réalisation.

Le

public concerné et impliqué par rapport aux pratiques de

l’évaluation est avant tout le personnel d’une organisation mais

aussi l’organisation elle-même mais aussi l’auditeur et le

public assigné à être évalué. Le public indirectement impliqué

est la société.

Les

attentes générales du public sont une évaluation juste et

correcte du travail et une évaluation qui reflète la réalité du

travail. Le besoin et le livrable particulier c’est d’avoir les

bonnes pratiques de l’évaluation.

C’est

pour cette raison que le contexte de notre travail est orienté

vers les soucis de cette réalité qui se reflète de par les

psychopathologies du travail, puis en prenant en compte la part

importante des organismes tertiaire d’où la prépondérance des

relations avec le client et le personnel dans la co-production

des services.

La mission de notre travail est

donc d’évaluer de

façon performante le système d’une organisation selon les

critères et indices spécifiés.

Les

priorités choisies à travailler sont la réalisation

d’une synthèse entre les normes d’évaluation et la réalité du

système évalué.

L’existence de normes et de

critiques sur le processus d’évaluation est notre support

ainsi que notre force mais la réalisation d’un guide des

bonnes pratiques reste notre domaine à développer et

élaborer et de le mettre en pratique dans une organisation.

Ceci constitue notre objectif mesurable.

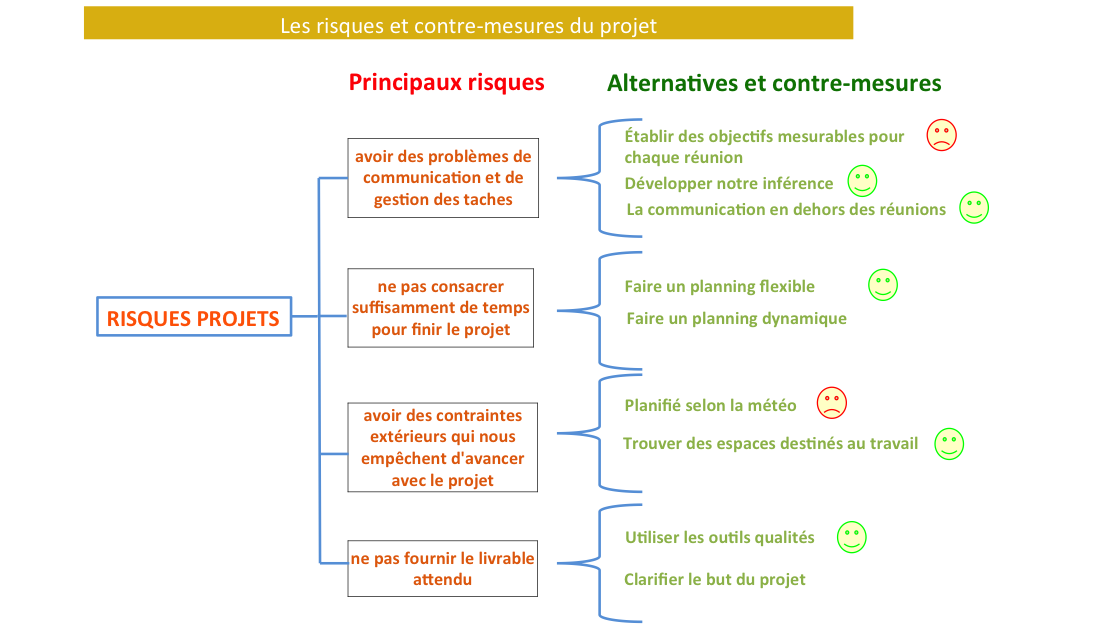

Dans l’optique de repérer

les contraintes potentielles qui risque de perturber le bon

déroulement du projet, une analyse des risques fut menée dans

le but de déceler les risques et les contre-mesures pour y

remédier.

Après un brainstorming et un

diagramme d’affinité, le tableau ci-dessous fut établi

regroupant les risques perçus par les membres du projet et la

famille de risques corresponde.

|

Famille de risques

|

Risques perçus

|

|

avoir des problèmes

de communication

et de gestion des taches

|

se perdre dans des détails

|

|

ne pas écouter les autres

|

|

ne pas clarifier la

thématique

|

|

avoir des problèmes de

gestion de tâche

|

|

de ne pas arriver à un

consensus

|

|

avoir des conflits dans

l'équipe de projet qui empêchent l'avancement

|

|

Ne pas consacrer

suffisamment de temps pour finir le projet

|

de ne pas avoir le temps pour

finir le projet

|

|

ne pas respecter les dates

limites

|

|

risque de ne pas mener le

projet avec des jalons prévus

|

|

avoir des

contraintes extérieures qui nous empêchent d’avancer

avec le projet

|

la météo nous empêche de nous

voir

|

|

de ne pas avoir d'internet

chez nous

|

|

ne pas disposer des

ressources pour réaliser notre projet (panne

ordinateur)

|

|

ne pas fournir le

livrable attendu

|

aller en cercle sans trouver

des bonnes pratiques

|

|

la peur de ne pas livrer

exactement ce que M.FARGE demande

|

|

risque que notre projet ne

serve à rien (aucune utilité)

|

|

risque de ne pas trouver une

solution concrète

|

|

de ne pas avoir des sources

d'inspirations

|

|

risques de faire hors sujet

|

|

d'aller sur la direction

erronée

|

|

avoir une mauvaise

compréhension du sujet

|

Ensuite les

alternatives pour chaque famille de risques (intrinsèquement

pour chaque risque perçu) fut identifié et représenté sous la

représentation ici-bas :

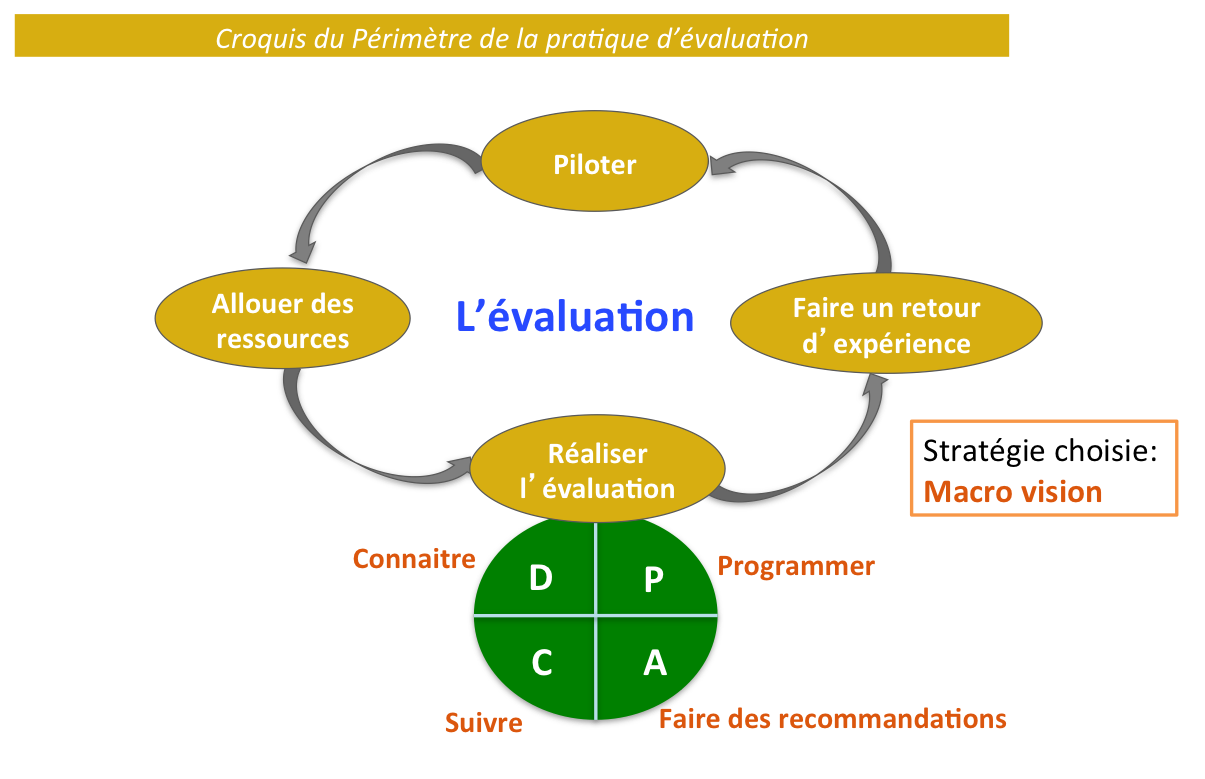

Maintenant que les

objectifs à atteindre et les risques sont identifiés, l’axe sur

lequel il est nécessaire d’entreprendre pour caractériser la pratique de l’évaluation se

schématise à partir du schéma dynamique du progrès selon l’ISO

9001. En effet, ce dernier récapitule selon un graphe la

coordination synthétique au sein d’une entité et il semble être

adéquat pour représenter les pratiques d’une évaluation sans

omettre les exigences essentielles de l’ISO 9001, telle

qu’une direction de pilotage de l’entité, puis un management des

ressources allouées pour la réalisation des objectifs fixés,

ensuite la réalisation de l’activité propre à l’entité selon un

cycle DCAP pour notre cas et une capitalisation par le retour

d’expérience. Ainsi, on peut visualiser le déroulement global

d’une évaluation. L’identification des pratiques est limité à

une vision macro pour une compréhension holistique de

l’évaluation.

De même, il

faut savoir que la pratique de l’évaluation peut se diviser en

deux sous ensembles, l’évaluation externe qui est une

appréciation d’une entité par un groupe d’évaluateur externe

avec la complicité de la direction alors que l’évaluation

interne est réalisé par les membres de l’entité, que se soit

les employés voir des partenaires.

Dans l’optique de

recadrer les pratiques d’évaluation actuelles, nous nous sommes

inspirées d’articles et d’ouvrages qui remettent en cause

l’évaluation de nos jours et présentent des pistes

d’améliorations dans le but d’identifier les raisons du

dysfonctionnement et y pallier. De ce fait, les membres du

groupe ont enregistré toutes les critiques d’une part et les points d’amélioration

d’autre part issus de ces différents textes. L’enregistrement

du tout fut procédé sur post-it pour les supports

bibliographiques physiques, tandis que les supports numériques

furent enregistrés directement via l’ordinateur.

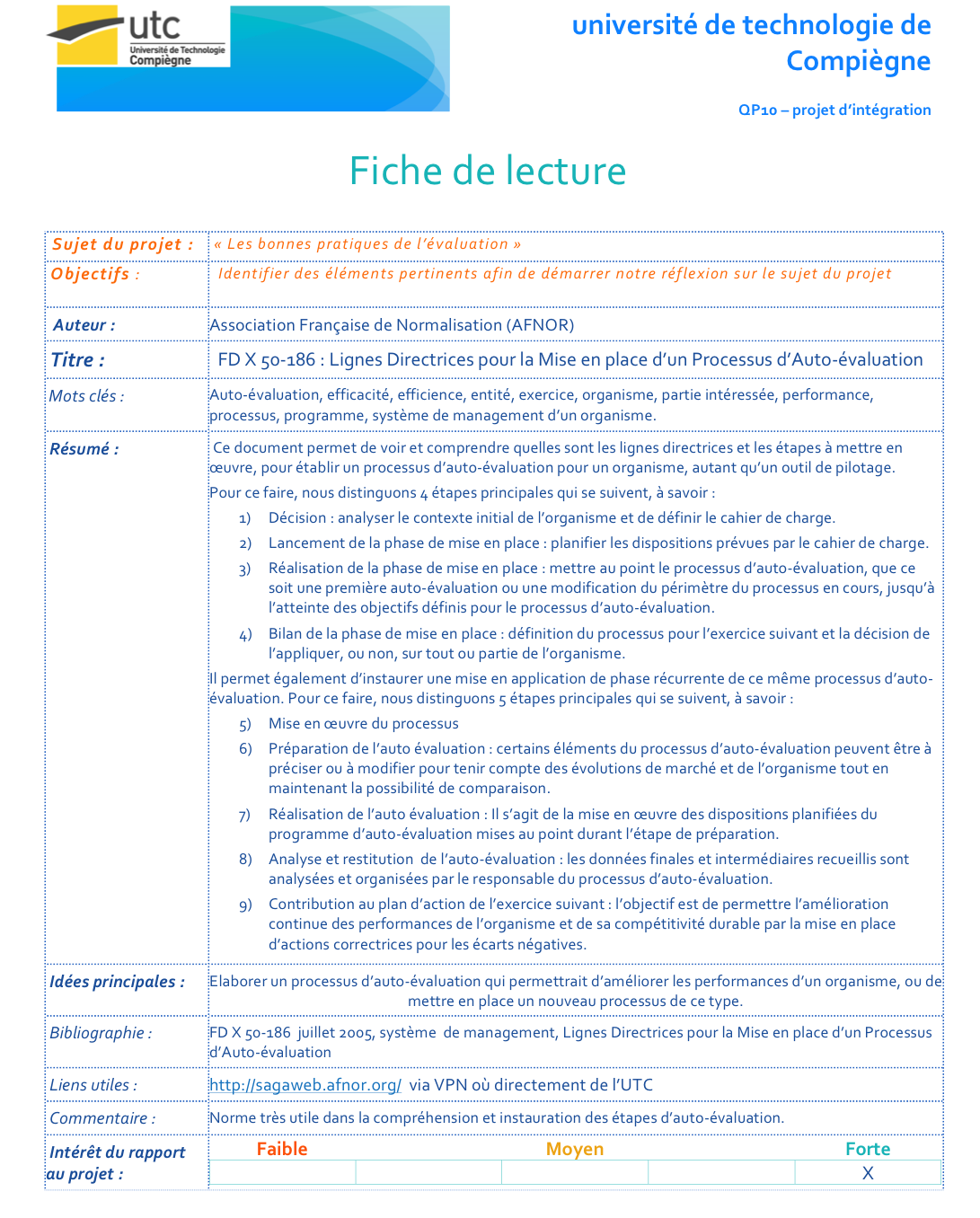

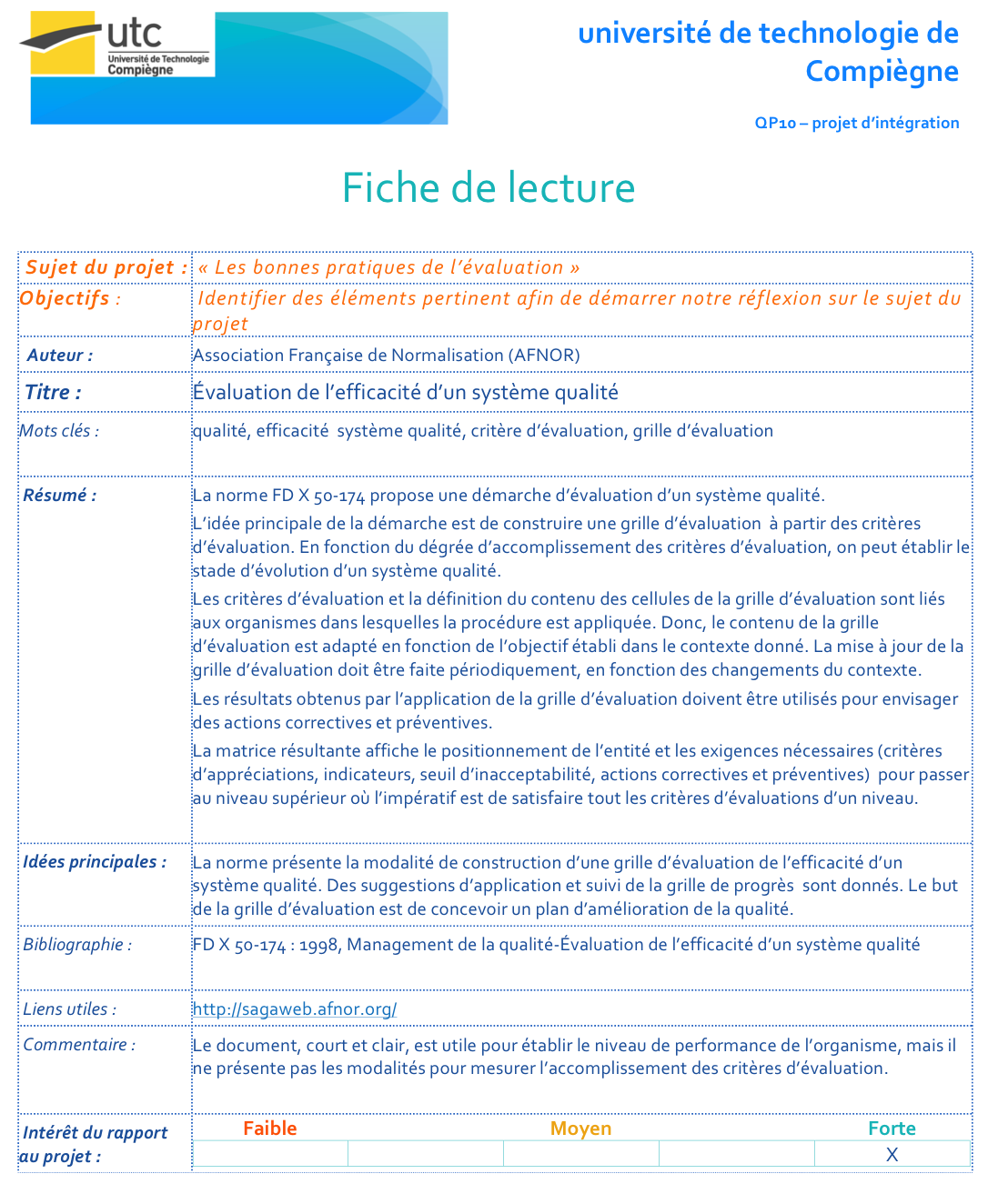

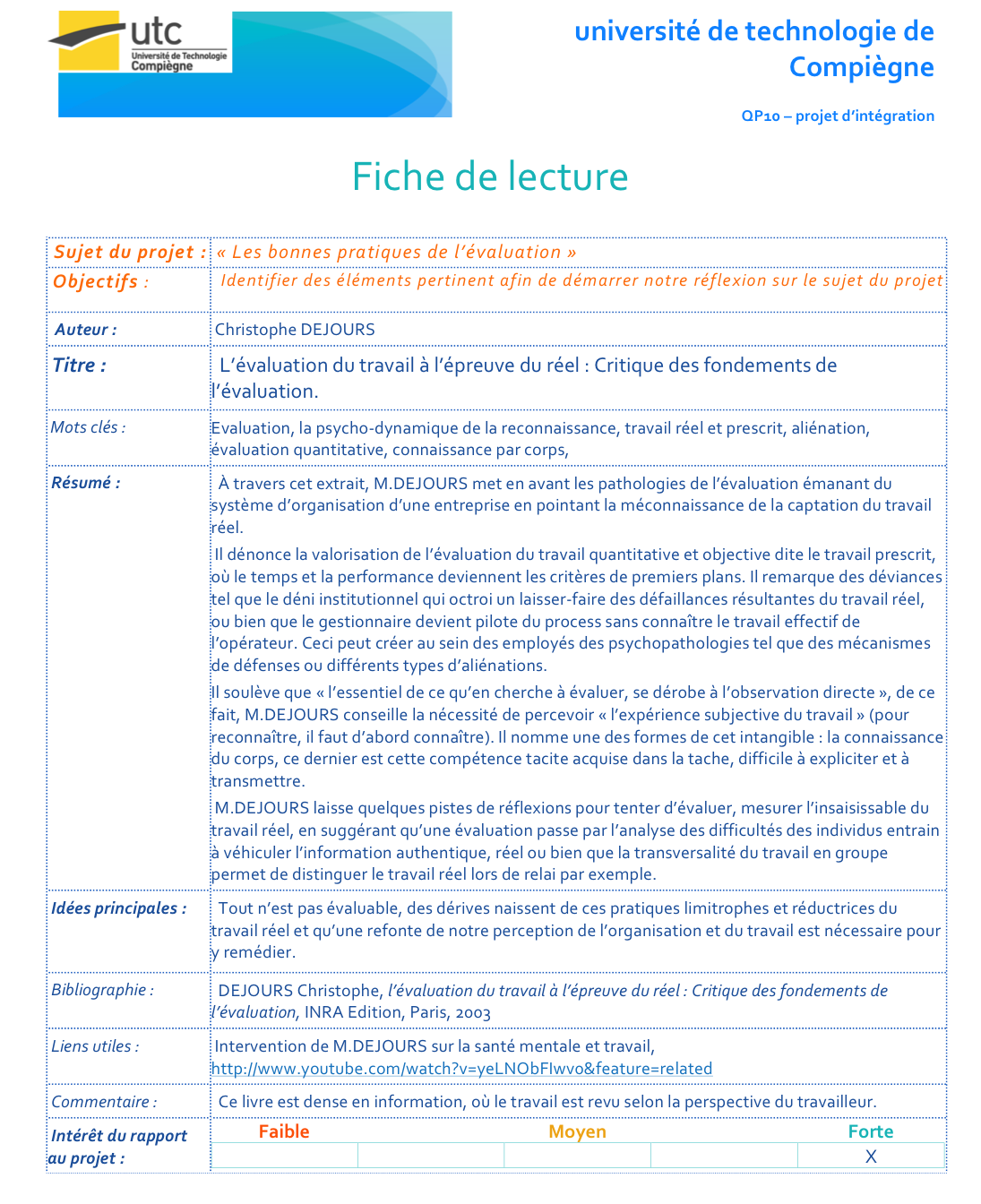

Ainsi, voici la liste

des appuis bibliographiques qui nous ont permis d’extraire les

éléments problématiques de la critique de l’évaluation et ces

solutions :

-

FD X 50-186 juillet

2005, système de

management, Lignes Directrices pour la Mise en place d’un

Processus d’Auto-évaluation

-

FD X 50-174 : 1998,

Management de la qualité - Évaluation de l’efficacité d’un

système qualité

-

Christophe DEJOURS , « l’évaluation du travail à l’épreuve du réel :

Critique des fondements de l’évaluation », INRA Edition,

Paris, 2003

- Christian

MARÉCHAL, « Comprendre

l'évaluation dans le secteur social et médico-social »,

lexitis Edition, 2011

-

Gabrielle BALAZS & Jean

pierre FARGUER, une

nouvelle forme de management : l’évaluation, Actes de

la recherche en sciences sociales. Vol. 114,

septembre 1996. pp. 68-78

- Claudine HAROCHE, « l’inévaluable

dans une société de défiance », PUF cahier

internationaux de sociologie, 2010, n ° : 128-129,

p 53-78

-

Danilo

MARTUCCELLI, « critique

de la philosophie de l’évaluation », P.U.F. | Cahiers

internationaux de sociologie 2010/1 - n° 128-129 -

pages 27 à 52

- Jean-Pierre GAUDIN et Pierre

LIVET, « Processus

d’évaluation des sciences sociales : acteurs et valeurs

», Revue européenne des sciences sociales [En ligne],

XLVI-141 | 2008,

-

Bernard PERRET, « L’évaluation des politiques

publiques »,

La Découverte & Syros, Paris, 2001.

- CNRS, « Comparaison des pratiques

d’évaluation individuelle et collective dans les

établissements publics de recherche », SECRETARIAT

GENERAL DU COMITÉ NATIONAL, 2008

-

Wing

S. CHOW et Lai Sheung CHAN,

« social network,

social trust and shared goals in organizational knowledge

sharing », Information and

Management, Elsevier 2008

-

Claire TOURMEN & lise

DEMAILLY, « évaluation en

tension : pour une critique documentée et constructive

de l’évaluation », | octobre-décembre 2011

-

Claire

TOURMEN, « Les compétences

des évaluateurs de politiques publiques », Formation

emploi [En

ligne], 104 | octobre-décembre 2008

De

surcroit, un interview avec une spécialiste de l’évaluation, Mde

TOURMEN fut effectué. Voici l’extrait de notre échange. Lors

de l’entretient avec Claire TOURMEN, elle a évoqué les causes de

la non évaluation ainsi que les solutions applicables pour

résoudre ce problème.

En

effet, dans un premier temps les causes principales du non

évaluation sont : la méfiance du contexte de l’évaluation,

manque de temps et des moyens ainsi que les compétences des

évaluateurs.

Dans un deuxième temps, nous distinguons :

l’environnement hostile, le scepticisme dans les résultats de

l'évaluation, différence entre la pratique et la théorie,

financement de l’évaluation et le manque du temps pour évaluer.

Les

solutions possibles et envisageables sont d’avoir les moyens

financiers puis de connaitre les finalités d’évaluation. Mais

aussi avoir le temps pour évaluer et prendre de bonnes décisions

de pratique selon le contexte. Par la suite, il faut connaitre

les finalités d’évaluation mais aussi avoir les référentiels

d’évaluation.

Souvent, ce qui est recherché à

évaluer sont le climat de travail, la souffrance, la

spécificité des locaux tout en demandant les avis des gens qui

y travaillent sur le bien-être des locaux, la gestion et

l’organisation du travail. Pour cela il faut construire un

référentiel d’évaluation avec les indicateurs adéquats comme

celui d’absentéisme. Notamment il existe une différence

d’évaluation entre les pays. Aux Etats-Unis, la méthodologie

d’évaluation est différente de celle élaborée en France car

elle s’adapte selon le contexte précis d’utilisation.

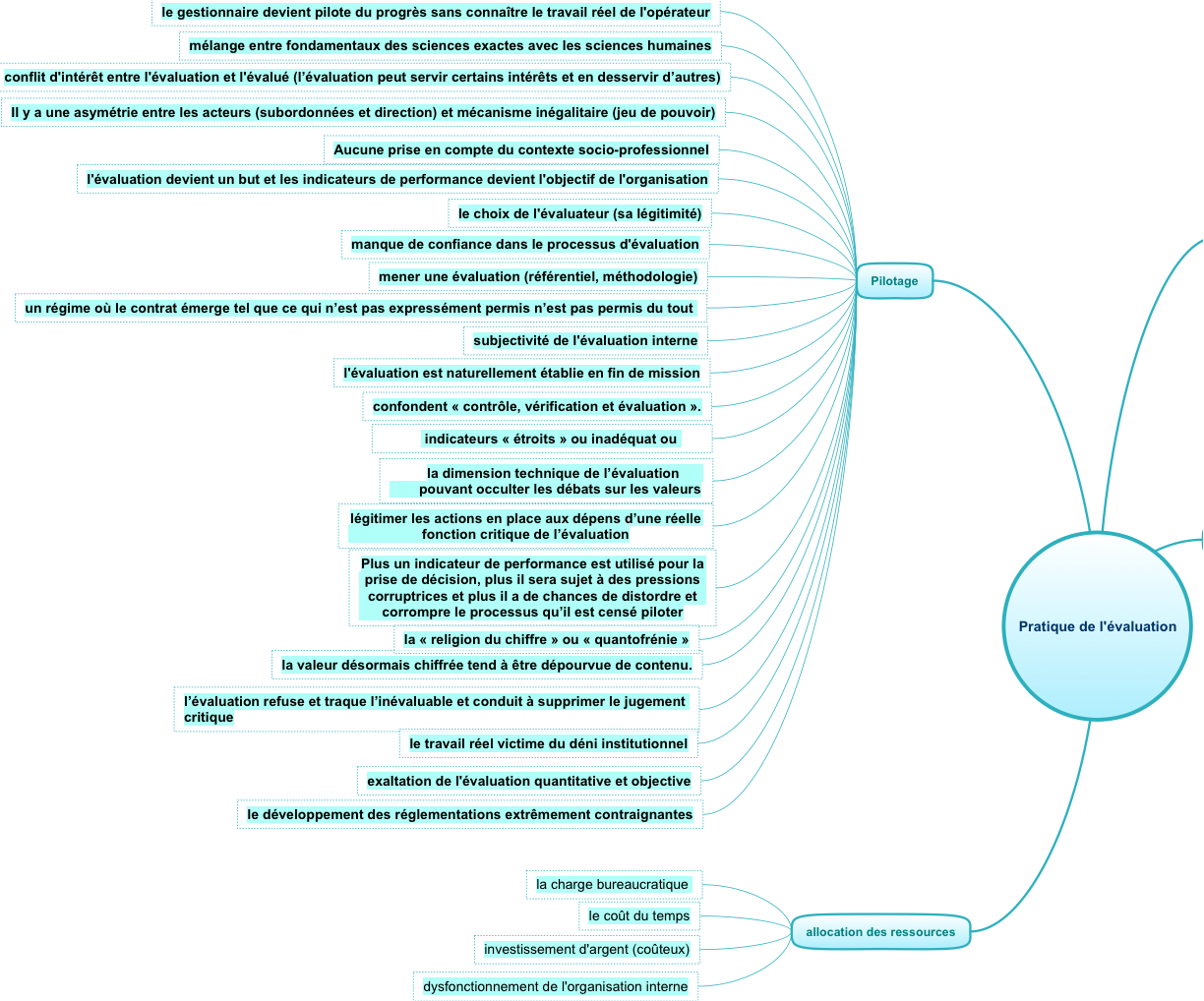

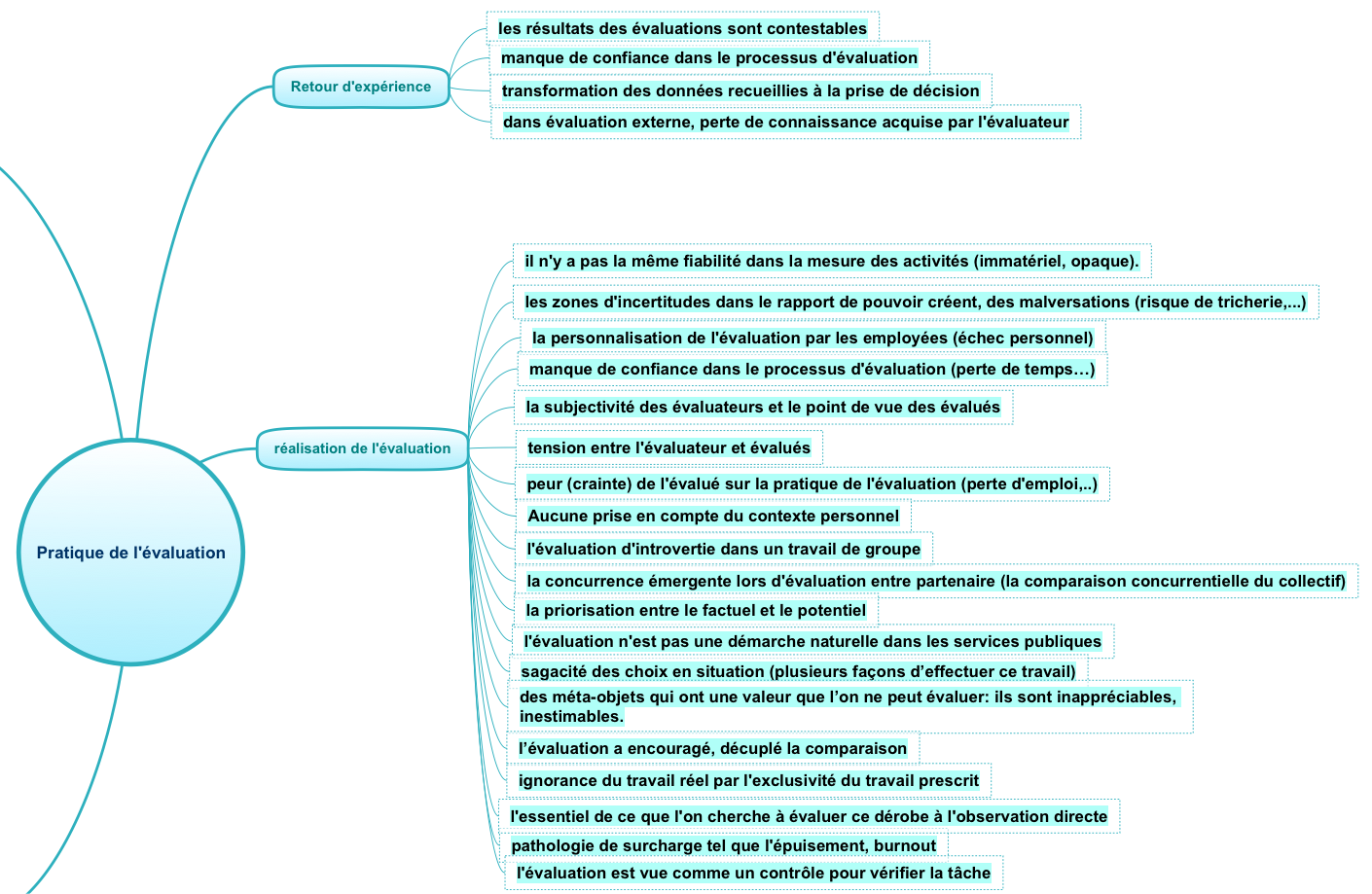

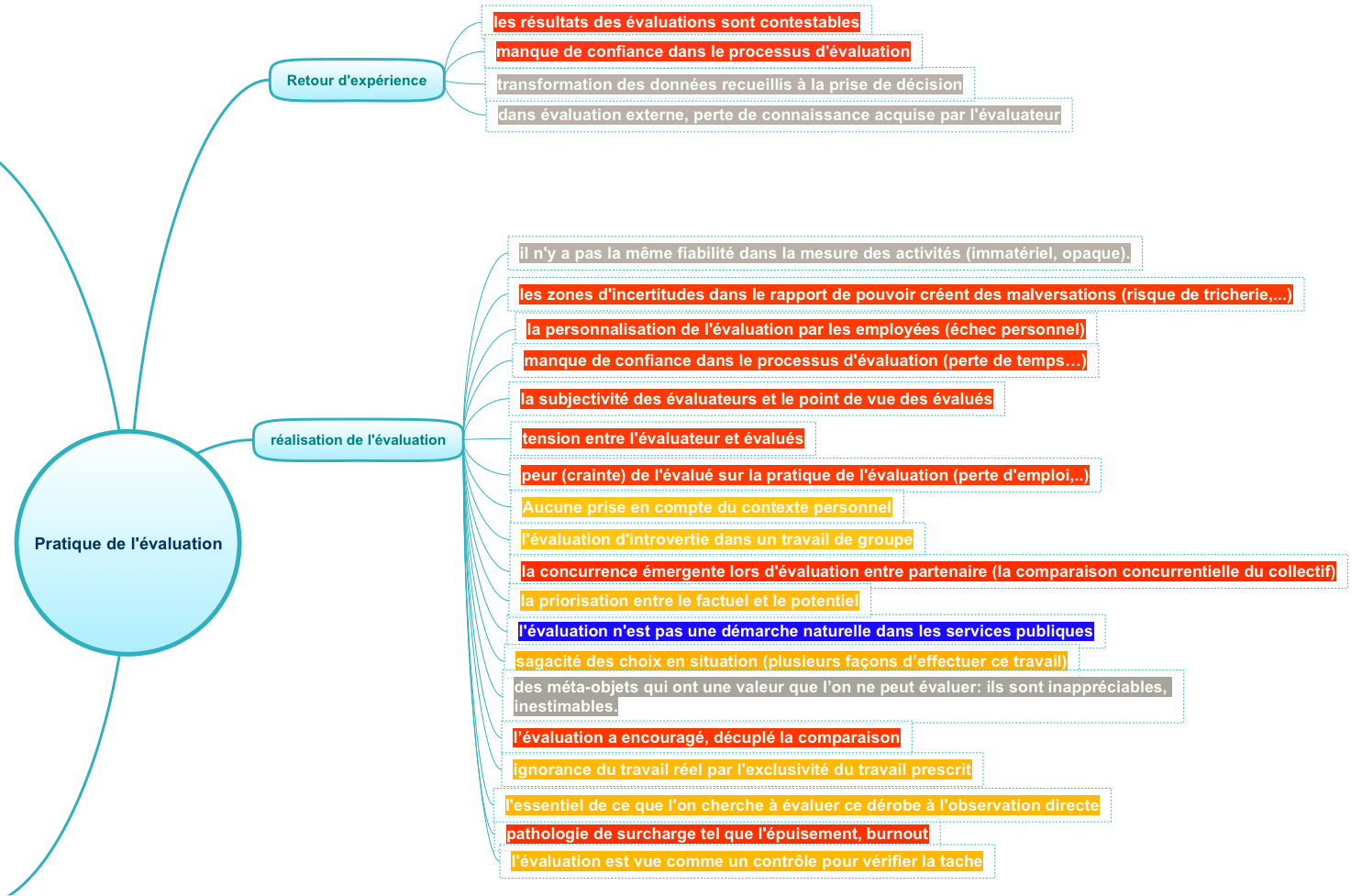

Afin de

discerner les pratiques dans chaque phase du déroulement d’une évaluation, les causes

furent regroupées selon la phase correspondante à l’aide d’un

MINDMAP. Puis les

solutions associées

issues des ouvrages et d’un brainstorming ont été

retranscrites dans cette représentation synthétique. Les

détails sont visibles en annexes

5, 6 et

dans un document complémentaire où tout les risques et

alternative sont explicités.

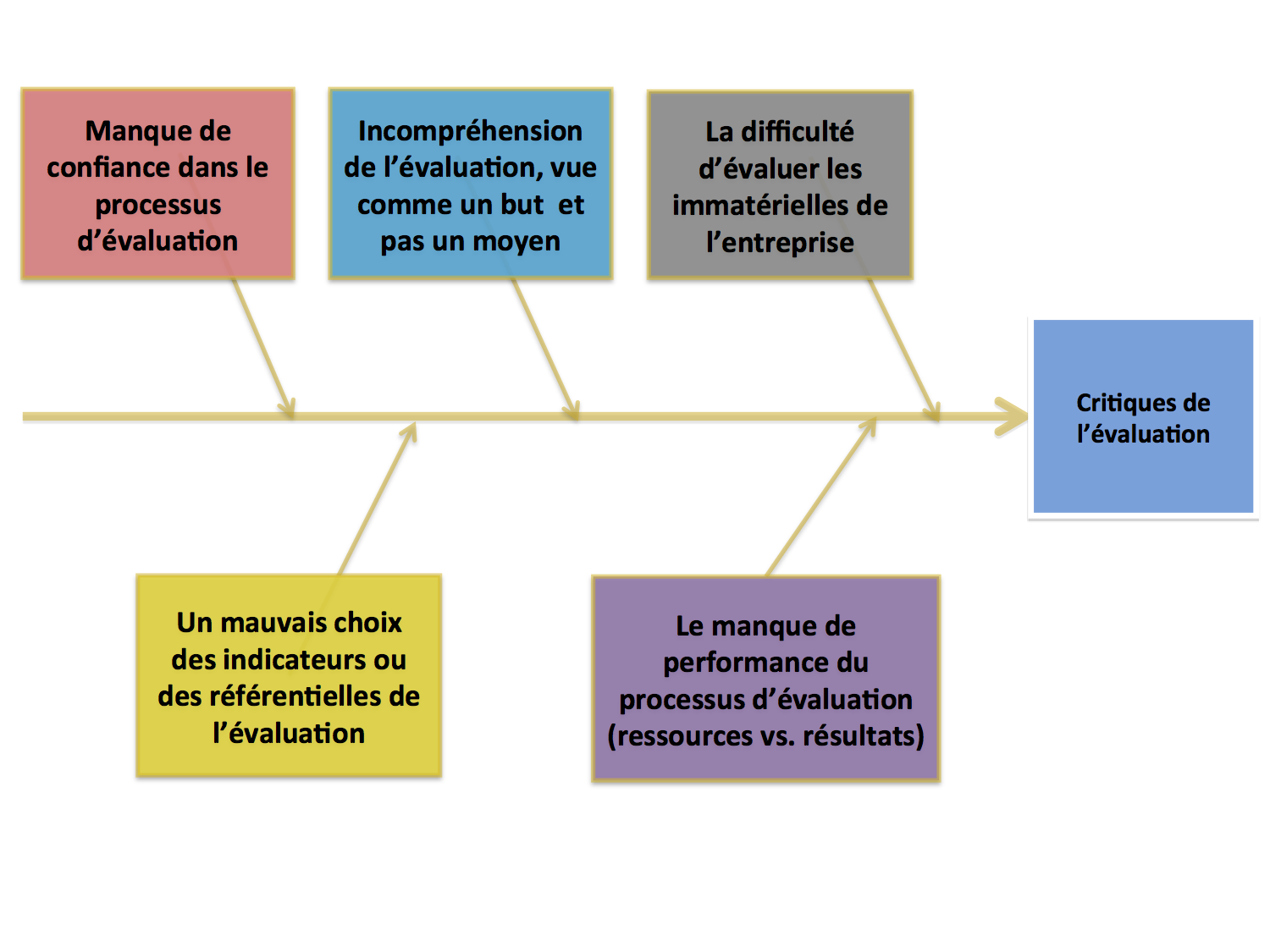

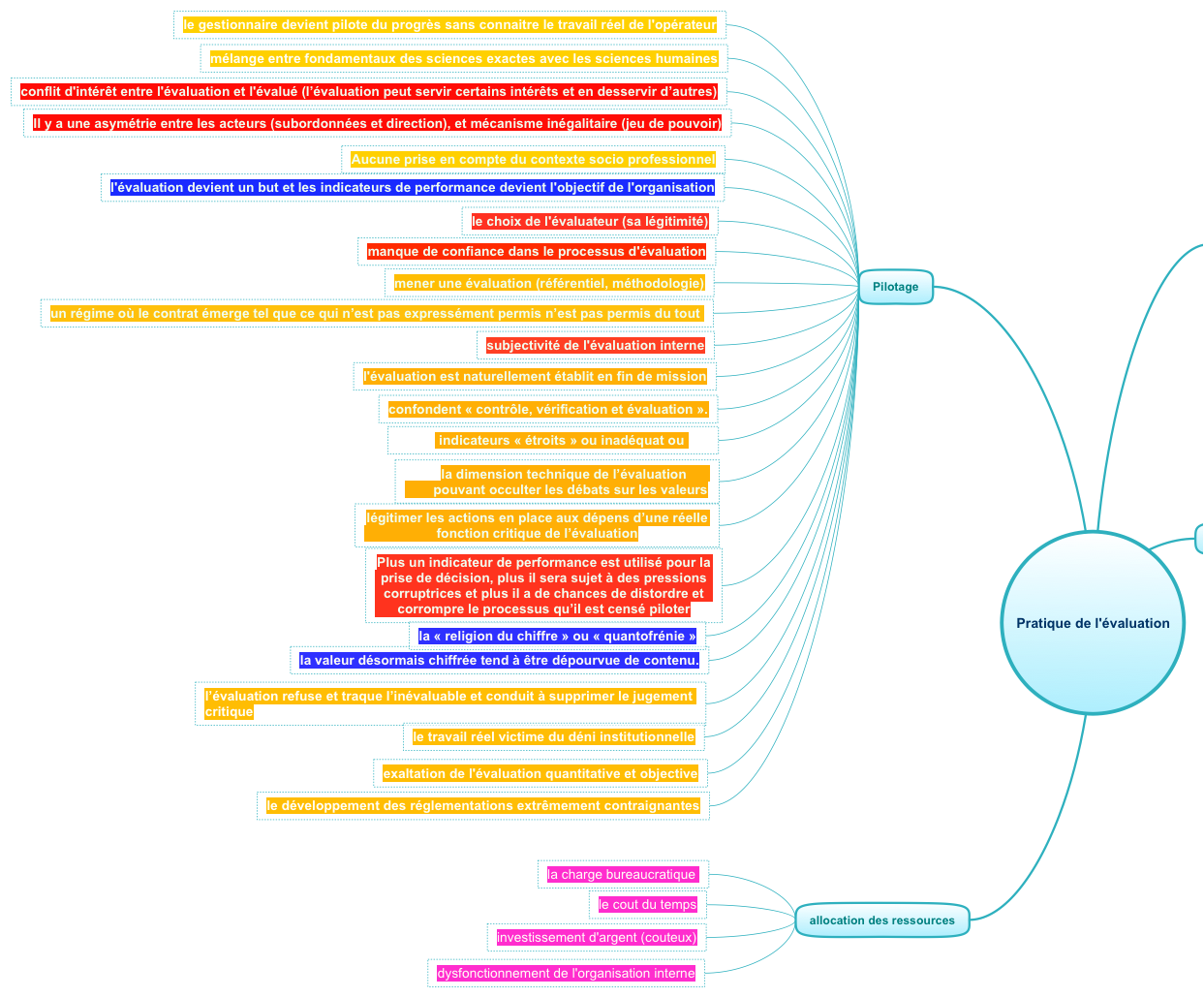

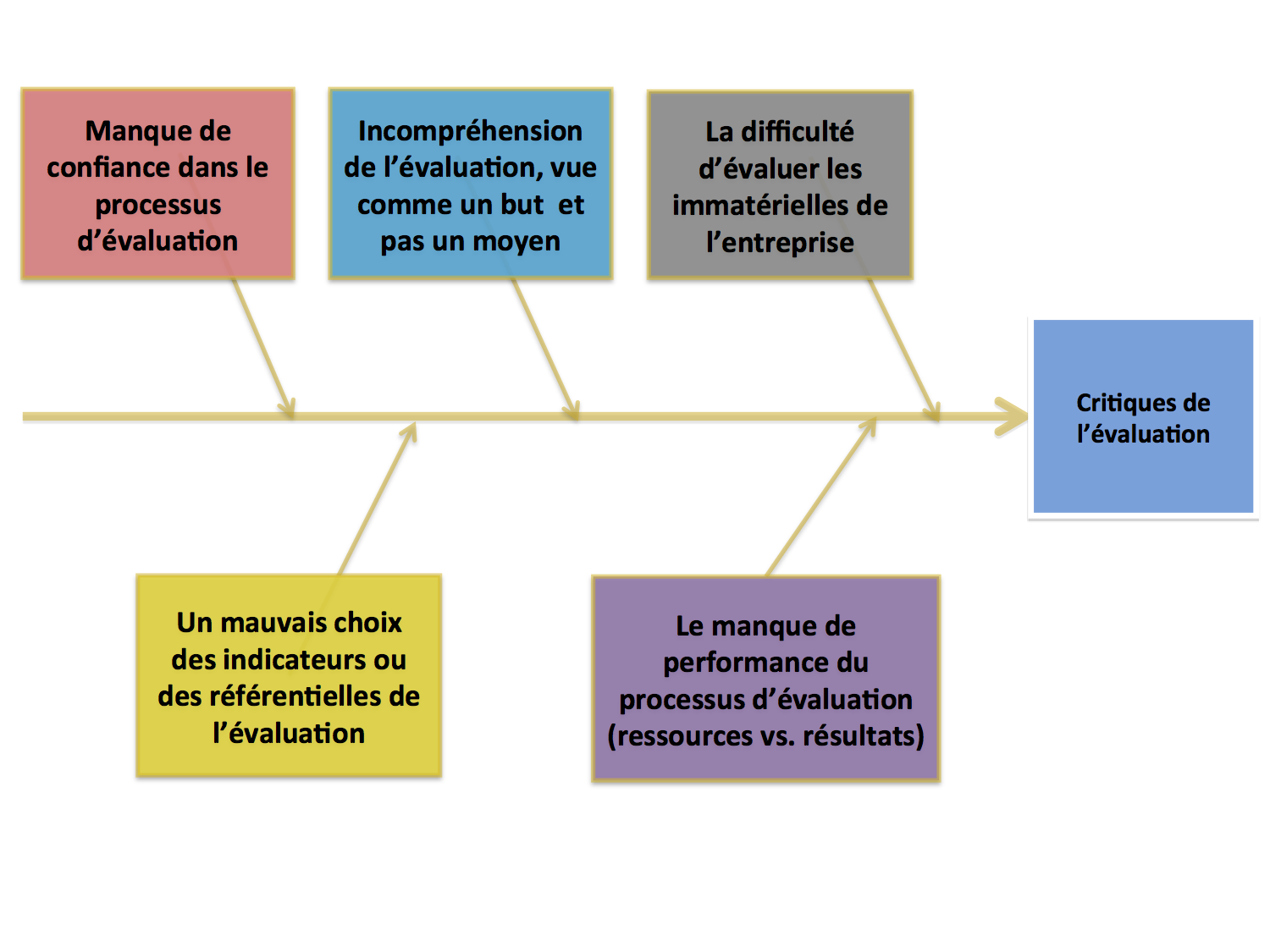

Une attention

particulière a été portée pour les causes (ou risques), où ces

dernières ont été classées dans des familles de risque

potentiellement responsables de la mauvaise appréciation de la

pratique de l’évaluation. En effet, un Ishikawa dynamique fut

opéré en prenant un par un tel risque repéré lors des lectures

et le classant dans les familles qui se créaient au fur et à

mesure. La technique employée fut de colorer sur la MINDMAP

chaque risque qui se ressemble en ayant l’objectif de

restreindre à 4,

voir 6 sous ensembles.

De ce fait,

on obtient l’Ishikawa ci-dessous :

Figure n° 4 :

Grandes familles des risques relatifs aux pratiques de

l’évaluation.

|

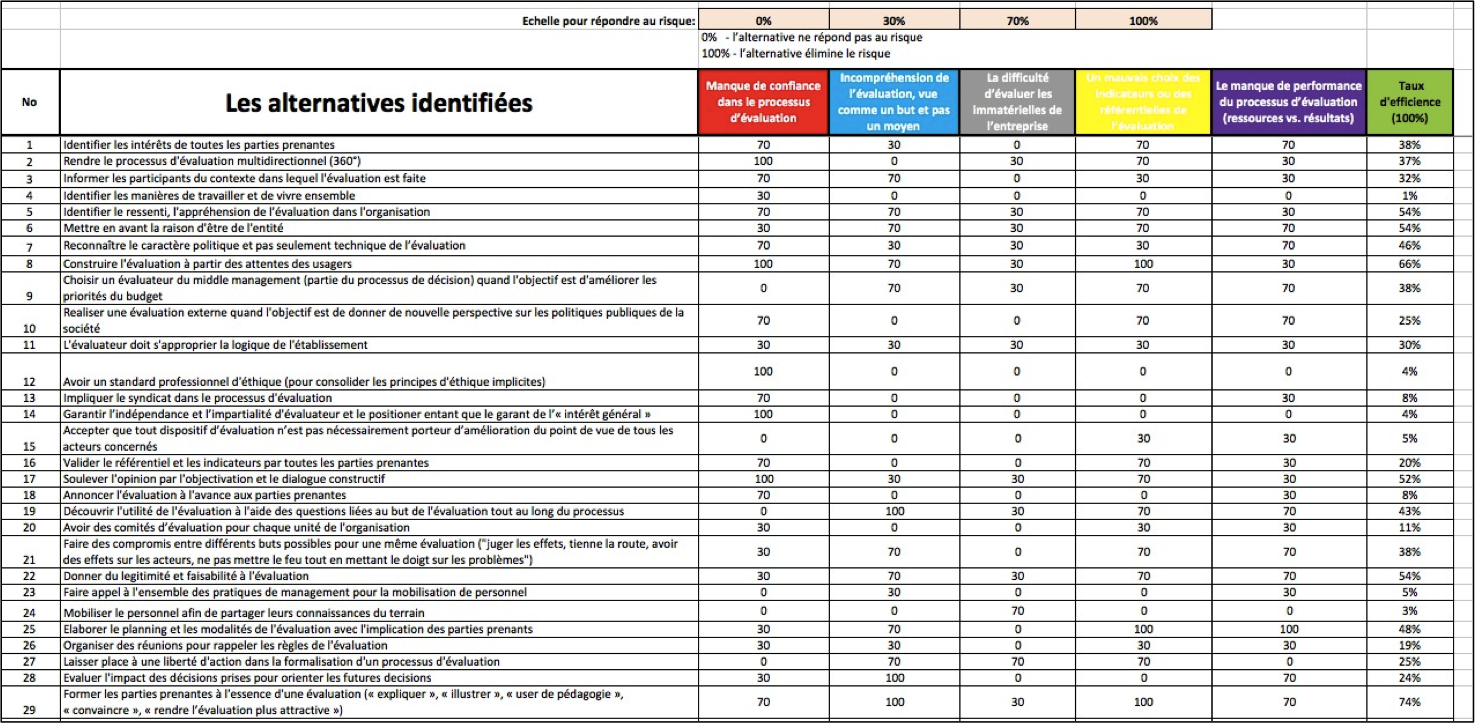

Maintenant que les

alternatives de chaque risque sont identifiées, il est

nécessaire de les sélectionner pour identifier les bonnes

pratiques de l’évaluation. Pour cela, une grille d’appréciation

des alternatives a été créée. Cette grille de sélection se base

sur les familles de risques discernées afin que chaque

alternative soit confrontée à chaque famille. Le principe réside

sur l’énonciation suivante : « l’alternative peut

répondre plus ou moins à une famille de risque ».

En se basant sur ce

principe, on peut pondérer notre appréciation d’une alternative

pour chaque famille de risque lié au critique de l’évaluation.

Dans notre situation, chaque membre du groupe va répondre à la

grille, et de ce

fait, va déterminer une valeur comprise parmi 0%, 30%, 70% et

100% (étant une suite de valeurs distinctes et sans valeur

médiane).

Ci-dessous, vous

avez l’échelle de notation de la grille :

|

Notation

|

Signification

|

|

0%

|

l’alternative

ne répond pas au risque

|

|

30%

|

l’alternative

élimine en partie le risque

|

|

70%

|

l’alternative

élimine en grande partie le risque

|

|

100%

|

l’alternative

élimine le risque

|

Ainsi, nous obtenons un jugement de valeur

d’une alternative de chaque membre pour chaque famille de

risque. Alors, une note moyenne est identifiée pour chaque

alternative déterminée par chaque membre. Cette note est issue

du calcul pondéré suivant:

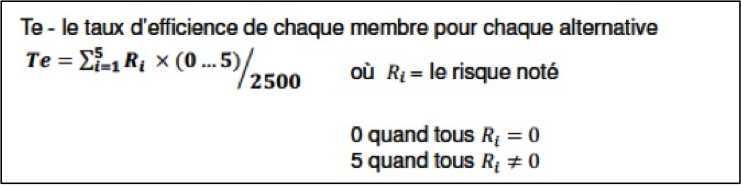

Ri est le risque noté, c’est à dire la

valeur attribuée par chaque membre pour la correspondance entre

une alternative et une famille de risque selon l’intervalle

définie. La somme des valeurs est ensuite pondéré selon qu’une

alternative répond (soit 30%, 70%, 100% d’où une valeur égale à

1) ou ne répond pas (soit 0% d’où une valeur de 0) à une famille

de risque (Ri). C’est donc la somme des réponses logiques qui

est multiplié par la somme des notations des risques et qui est

divisé par 2500 pour ramener à un Taux d’efficience (Te) compris

entre 0% et 100%.

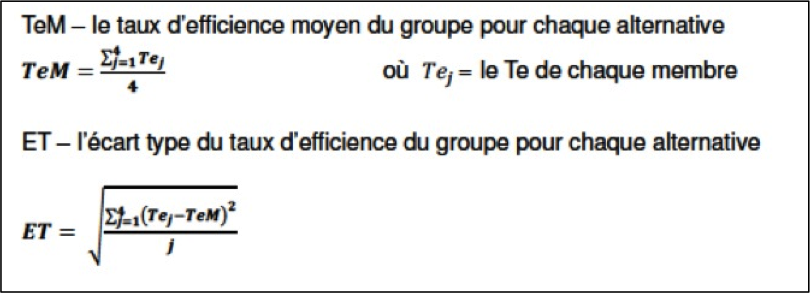

Ensuite, le Taux

d’efficience Moyen (TeM) qui correspond à la moyenne des Te de

tous les membres est déduit. (Rappelant la nature subjective et

personnel de la détermination des valeurs par chaque membre,

rendant le TeM contextuel et propre).

Le Taux d’efficience

Moyen (TeM) est un critère de sélection des alternatives.

De même,

l’écart type (ET) du Te entre les membres par rapport à la TeM

est envisagé dans notre analyse, ainsi, on peut visualiser

l’écart des notations pour une alternative. Voici les calculs

correspondants :

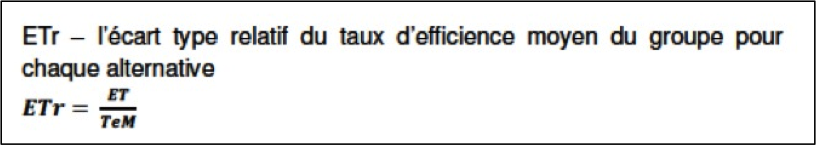

Du fait de la

nature épistémologique distinct des alternatives (fait

référence à une action particulière, des qualificatifs

orientant l’appréciation,…), il est préférable de relativiser

chaque écart type de chaque TeM dans le but d’obtenir un

second critère de sélection : l’Ecart Type relative (ETr)

de formule suivante :

Donc, il est possible

de filtrer les alternatives selon deux critères précédemment

définis :

-

le TeM, le Taux

d’Efficience Moyen du groupe pour chaque alternative, qui permet

de distinguer les alternatives répondant plus ou moins aux

différentes familles de risques.

-

Le ETr, l’Ecart Type

relatif du TeM pour chaque alternative, qui permet de montrer

les écarts d’appréciations du groupe par rapport à une

alternative.

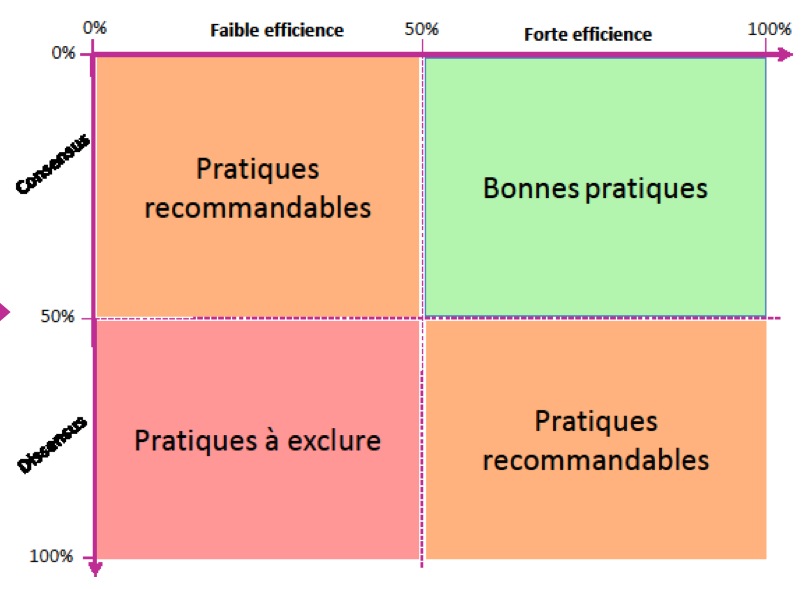

Afin de nuancer notre

approche sur les pratiques dans le processus de l’évaluation,

une qualification graduée du TeM

et du ETr fut nécessaire. Le TeM est divisé en deux sous

ensemble :

- faible efficience

quand le TeM est compris entre 0% et 50% et

- forte efficience

quand le TeM est compris entre 50% et 100%

Tandis que l’ETr, ce

critère est séparé de la manière suivante :

- dissensus quand l’ETr

est compris entre 0% et 50% et

- consensus quand

l’ETr est compris entre 50% et 100%

Ainsi, on

obtient une matrice qui se schématise comme suit :

Voici le

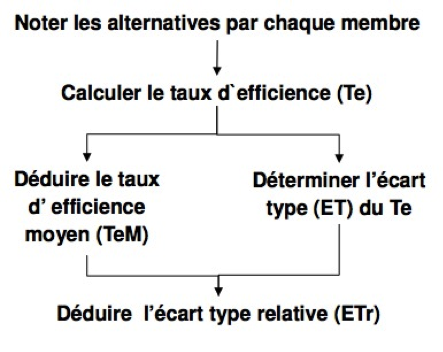

processus récapitulatif de sélection des alternatives :

La

totalité de la démarche statistique effectuée est regroupé dans

un fichier EXCEL personnalisable et adaptable selon le contexte.

D’où l’obtention d’un outil de sélection des bonnes pratiques de

l’évaluation. Cet outil présente les caractéristiques

suivantes :

Fonctionnelle

-

Contextuel

-

personnalisable

-

robuste

-

nuancé

Technique

-

Possibilité d’ajouter des

alternatives dans la colonne correspondante

-

Possibilité d’émettre de

nouveau critère de sélection des alternatives

-

Le choix du seuil de la

limite de l’efficience du TeM et du consensus selon l’ETr

-

Paramétrage du tri des

colonnes

Ci-dessous,

on peut visualiser un extrait de l’outil de sélection des bonnes

pratiques de l’évaluation :

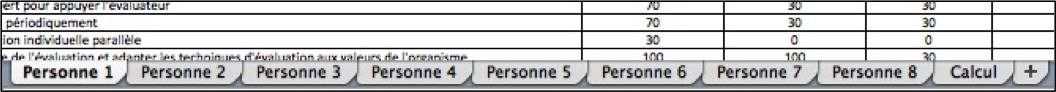

Les onglets visibles dans le schéma ci-dessus montre

les personnes participant à la notation de la grille et avec un

onglet dit ‘calcul’ qui regroupe les critères et TeM des

alternatives.